การศึกษาเรื่อง AI Bias และ Fairness

AI Bias คือปัญหาที่เกิดขึ้นเมื่อระบบปัญญาประดิษฐ์ (AI) หรือแบบจำลองทางคณิตศาสตร์มีการตัดสินใจหรือการทำนายที่เอื้อต่อกลุ่มบางกลุ่มและไม่เอื้อต่อกลุ่มอื่น ๆ ซึ่งอาจทำให้เกิดความไม่เท่าเทียมและความยุติธรรมในการทำให้ประสบการณ์หรือผลลัพธ์ที่ไม่ถูกต้องสำหรับบุคคลหรือกลุ่มที่ถูกกำหนดให้เป็นกลุ่มหมวดหมู่ใดๆ

ปัญหานี้สามารถเกิดขึ้นเนื่องจากข้อมูลที่ใช้ฝึกอบรมแบบจำลองมีความเอื้อต่อแบบความยุติ ยกตัวอย่างเช่น หากแบบจำลองถูกฝึกด้วยข้อมูลที่มีแบบแผนการเลือกบุคคลในตำแหน่งบนเทคโนโลยีสูง แล้วระบบอาจมีความเอื้อต่อเหล่าคนในตำแหน่งนั้นมากกว่าคนในตำแหน่งที่ต่ำกว่า ซึ่งทำให้การตัดสินใจเป็นไปไม่เท่าเทียมและยุติธรรม

เรื่องการให้ความยุติและความไม่เท่าเทียมเกิดขึ้นในแบบจำลอง AI ไม่ได้เกี่ยวข้องเฉพาะกับข้อมูลการฝึกอบรมเท่านั้น แต่ยังเกี่ยวข้องกับขั้นตอนอื่น ๆ ในกระบวนการสร้างและใช้งาน AI ด้วย เช่น การเลือกคุณสมบัติ (feature selection), การปรับแต่งแบบจำลอง, การกำหนดน้ำหนักในการทำนาย, และอื่นๆ

เพื่อแก้ไขปัญหา AI Bias และความไม่เท่าเทียมในระบบปัญญาประดิษฐ์ การศึกษาและปฏิบัติตามหลักการ Fairness จึงเป็นสิ่งสำคัญ แนวทางสำคัญที่ช่วยในการแก้ไขปัญหาเหล่านี้ได้คือ:

1.การตรวจสอบและประเมิน : ตรวจสอบและประเมินระบบปัญญาประดิษฐ์เพื่อระบุความยุติและความไม่เท่าเทียม และทำการทดสอบกับกลุ่มที่แตกต่างกัน

2.การสร้างข้อมูลที่แยกแยะและเคร่งครัด : สร้างข้อมูลที่แยกแยะและไม่มีความยุติเพื่อฝึกอบรมแบบจำลอง

3.การปรับแต่งและตรวจสอบแบบจำลอง : ปรับแต่งและตรวจสอบแบบจำลองเพื่อลดความยุติและความไม่เท่าเทียม

4.การใช้เทคนิคเชิงคณิตศาสตร์ : ใช้เทคนิคทางคณิตศาสตร์เพื่อปรับน้ำหนัก, แก้ไขค่าในแบบจำลอง, และปรับแก้ความยุติ

5.การควบคุมและการโปรแกรมแบบจำลอง : ควบคุมกระบวนการทำงานของแบบจำลองเพื่อให้มั่นใจว่าการตัดสินใจที่ตัดสินใจถูกต้องและไม่มีความยุติ

6.การควบคุมการส่งผ่านและการใช้งาน : ปรับน้ำหนักหรือปรับแต่งแบบจำลองก่อนการนำไปใช้งานจริงเพื่อให้มั่นใจว่ามีความเท่าเทียมและไม่มีความยุติในผลลัพธ์ที่สร้างขึ้น

การแก้ไขปัญหา AI Bias และ Fairness เป็นส่วนสำคัญในการพัฒนาและปรับใช้ระบบปัญญาประดิษฐ์ในสังคม ทำให้ระบบที่ถูกสร้างขึ้นมีความยุติน้อยลงและมีความเท่าเทียมในการให้บริการแก่ทุกกลุ่มคน

ที่มา: ChatGPT

AI วิเคราะห์เลขท้าย 2 ตัว งวดวันที่ 1 มีนาคม 69..โดยใช้สถิติย้อนหลัง 20 ปี

AI วิเคราะห์เลขท้าย 2 ตัว งวดวันที่ 1 มีนาคม 69..โดยใช้สถิติย้อนหลัง 20 ปี "เดินยังไงให้มันกร้าวใจได้ขนาดนี้กันนะ..." นี่คือท่าเดินในตำนาน และเรื่องราวเกี่ยวกับนก "Jackal Buzzard" นกนักล่าแห่งแอฟริกาใต้

"เดินยังไงให้มันกร้าวใจได้ขนาดนี้กันนะ..." นี่คือท่าเดินในตำนาน และเรื่องราวเกี่ยวกับนก "Jackal Buzzard" นกนักล่าแห่งแอฟริกาใต้ เมืองหลวงที่สวยที่สุดในอาเซียน

เมืองหลวงที่สวยที่สุดในอาเซียน พนมเปญระส่ำ! ค่าครองชีพพุ่ง 30% แรงงานเขมรทะลักกลับบ้านเฉียดล้าน เศรษฐกิจพังยับจนต้องวิ่งไปง้อทรัมป์!

พนมเปญระส่ำ! ค่าครองชีพพุ่ง 30% แรงงานเขมรทะลักกลับบ้านเฉียดล้าน เศรษฐกิจพังยับจนต้องวิ่งไปง้อทรัมป์! AI วิเคราะห์เลขเด็ด น่าจะออกรางวัลงวดวันที่ 1 มีนาคม 2569

AI วิเคราะห์เลขเด็ด น่าจะออกรางวัลงวดวันที่ 1 มีนาคม 2569 ชีวิตในห้องหมายเลข 1: เมื่อคู่รักวัยเกษียณเลือก "เช็กอิน" โรงแรมเป็นบ้านถาวรนานกว่า 22 ปี

ชีวิตในห้องหมายเลข 1: เมื่อคู่รักวัยเกษียณเลือก "เช็กอิน" โรงแรมเป็นบ้านถาวรนานกว่า 22 ปี หัวใจทำด้วยอะไร? ทำไมสัตว์ตัวแค่นี้ถึงกล้าบวกกับทั้งป่า

หัวใจทำด้วยอะไร? ทำไมสัตว์ตัวแค่นี้ถึงกล้าบวกกับทั้งป่า บทเรียนราคาแพงของธุรกิจบริการ: เมื่อ "สภาพไม่ผ่าน" กลายเป็นเหตุผลในการปฏิเสธลูกค้า

บทเรียนราคาแพงของธุรกิจบริการ: เมื่อ "สภาพไม่ผ่าน" กลายเป็นเหตุผลในการปฏิเสธลูกค้า ชวนลองเข้ามาดูภาพลวงตาชวนงงที่จะทำให้คุณทึ่งได้ถ้ามองใกล้ ๆ อีกสักหน่อย

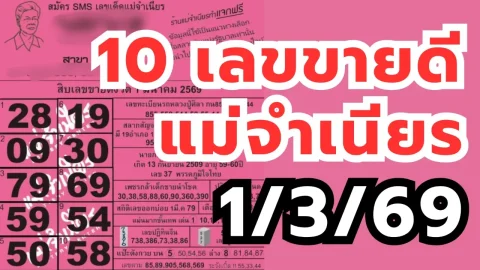

ชวนลองเข้ามาดูภาพลวงตาชวนงงที่จะทำให้คุณทึ่งได้ถ้ามองใกล้ ๆ อีกสักหน่อย สิบเลขขายดีแม่จำเนียร งวด 1/3/69

สิบเลขขายดีแม่จำเนียร งวด 1/3/69 🔥 กระทู้รวมเลขดัง 1 มีนา 69 เลขไหนมาแรงสุดในโซเชียล

🔥 กระทู้รวมเลขดัง 1 มีนา 69 เลขไหนมาแรงสุดในโซเชียล คิดยังไง? กฏใหม่ ตรวจกระเป๋าเดินทาง หากจนท.สงสัยว่ามีของต้องห้าม สามารถเปิดกระเป๋าโหล ไม่ต้องแจ้ง-พังล็อกไม่จ่ายคืน

คิดยังไง? กฏใหม่ ตรวจกระเป๋าเดินทาง หากจนท.สงสัยว่ามีของต้องห้าม สามารถเปิดกระเป๋าโหล ไม่ต้องแจ้ง-พังล็อกไม่จ่ายคืน ต้นไม้ที่มีหลักฐานน่าเชื่อถือว่าเป็นต้นไม้ที่มีอายุมากที่สุดในทวีปเอเชีย

ต้นไม้ที่มีหลักฐานน่าเชื่อถือว่าเป็นต้นไม้ที่มีอายุมากที่สุดในทวีปเอเชีย คิดยังไง? กฏใหม่ ตรวจกระเป๋าเดินทาง หากจนท.สงสัยว่ามีของต้องห้าม สามารถเปิดกระเป๋าโหล ไม่ต้องแจ้ง-พังล็อกไม่จ่ายคืน

คิดยังไง? กฏใหม่ ตรวจกระเป๋าเดินทาง หากจนท.สงสัยว่ามีของต้องห้าม สามารถเปิดกระเป๋าโหล ไม่ต้องแจ้ง-พังล็อกไม่จ่ายคืน ราคาประเมินค่าก่อสร้างอาคาร พ.ศ. 2569 (ธันวาคม 2568)

ราคาประเมินค่าก่อสร้างอาคาร พ.ศ. 2569 (ธันวาคม 2568) ชายสูงอายุถูกปรับเงิน ฐานจุดประทัดใส่สุนัขจรจัดจนตๅย

ชายสูงอายุถูกปรับเงิน ฐานจุดประทัดใส่สุนัขจรจัดจนตๅย